09/02/2022

Digital Technology Insights

Self-BI : Dat’Iceberg en vue !

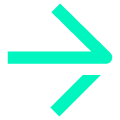

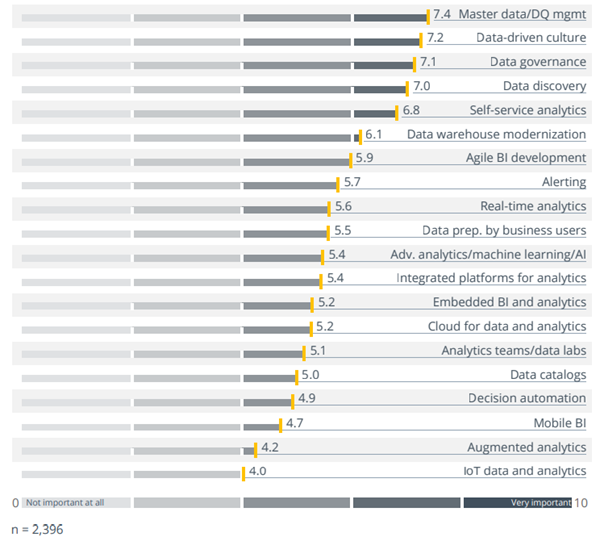

Culture, gouvernance et qualité… Voilà les 3 priorités en matière de « Data Strategy » sur lesquelles les entreprises s’accordent cette année encore [1], quels que soient leur secteur d’activité, leur plaque géographique ou leur maturité sur ces sujets.

Et ce depuis plus de 5 années consécutives alors que le monde connait une accélération sans précédent avec dans son sillage son lot d’injonctions (à priori) paradoxales…

Les marqueurs d’une transition

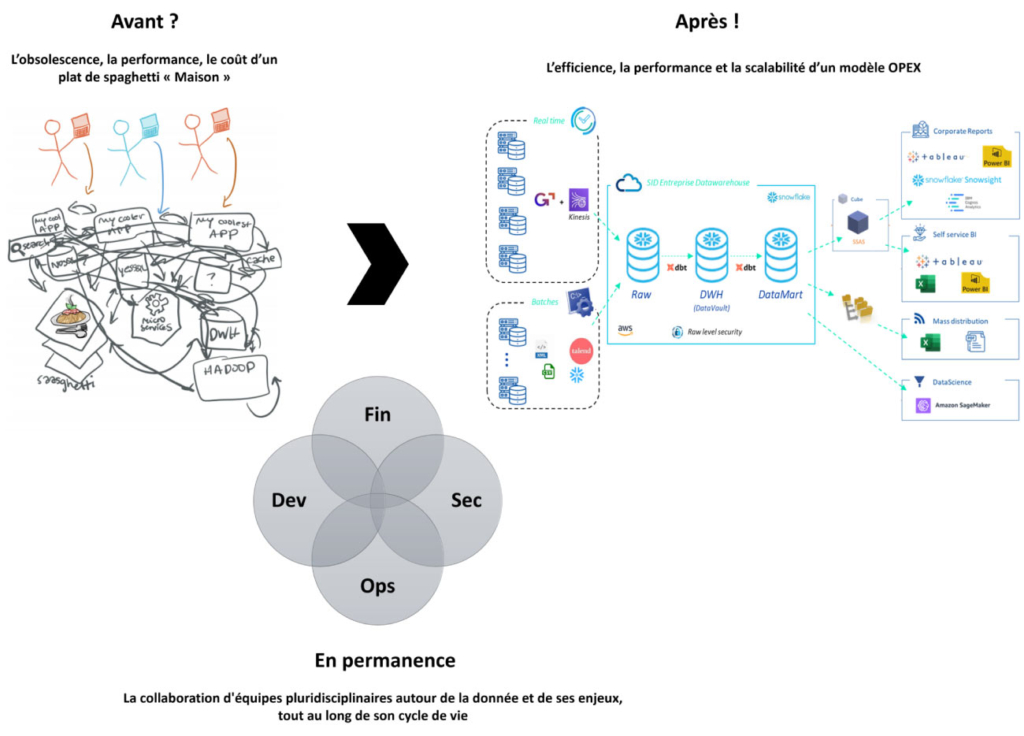

Figure 1: L’injonction paradoxale à l’échelle de l’entreprise

La multiplicité de ces changements tant en fréquence qu’en nature, met à mal l’entreprise et l’ensemble de son écosystème. Alors pour préserver sa « santé » (business model, performance, pérennité…), le besoin de fiabilisation et de valorisation de l’information devient chaque jour plus prononcé.

Avec encore et toujours le même objectif : mieux décider pour mieux agir (cf. notre article « La Gouvernance de Données : votre passeport vers la création de valeur »). Pas étonnant dans ce contexte que la Self-BI trouve une nouvelle fois sa place au top 5 des tendances Data, BI and Analytics de 2022 selon BARC [1].

Figure 2: « Data, BI, and Analytics Top trends » 2022 selon BARC

Car tout l’enjeu est là : bâtir le socle technologique, organisationnel et culturel nécessaire à l’autonomisation des métiers (indépendance ET responsabilité) en matière de consommation du patrimoine informationnel de l’entreprise. De sorte que l’intelligence économique devienne une compétence décentralisée qui concourt au développement de l’intelligence collective.

En clair, c’est donner la capacité aux utilisateurs finaux d’accéder à des sources de données fiables et d’en tirer la valeur attendue en construisant et en déployant leurs propres analyses et reportings (voire modèles de données pour les plus aguerris), et ce sans recourir à l’IT.

Il s’agit donc de créer au sein même de l’entreprise un nouvel écosystème fondé sur la confiance et répondant à de nouvelles règles d’engagement visant à concentrer, orchestrer et associer données, compétences, processus et personnes.

[1] Data, BI and Analytics Trend Monitor 2022, BARC – Business Application Research Center

La transformation en prérequis

Les promesses de la Self-BI sont nombreuses et ont toutes pour objet la valorisation du patrimoine informationnel de l’entreprise :

- L’amélioration des processus de création de valeur et d’aide à la décision,

- L’amélioration de la performance et de l’agilité des métiers (time to market),

- Le développement d’une culture du pilotage et de l’innovation par la Donnée,

- Le développement de la relation partenariale entre IT et métiers.

Pour autant, ces promesses ne pourront être tenues qu’à cette unique condition : une transition IT réussie vers le Data Enablement. En d’autres termes, la mise en œuvre et le support efficace de l’architecture et des processus qui garantiront que la bonne information soit délivrée à la bonne personne et au bon moment afin qu’elle puisse prendre la meilleure décision possible et agir en conséquence. Et ce en conformité avec les standards éthiques, réglementaires et de sécurité qui s’imposent à la structure.

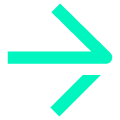

Sans pousser trop loin la métaphore, le modèle culturel de l’iceberg d’Edward T.Hall s’applique ici parfaitement : les parties immergées (c’est-à-dire la valeur produite) n’étant que l’expression des parties submergées (rassemblant prérequis et fondamentaux).

Figure 3: La Self-BI, le changement de paradigme

La Self-BI n’est donc pas uniquement une affaire d’outils et elle ne peut se limiter aux seuls talents du bricoleur. Bien au contraire ! Elle s’inscrit dans une démarche globale relevant davantage du programme de transformation que du projet de déploiement applicatif.

Sur le plan technologique, on portera une attention particulière à la performance et la scalabilité de la plateforme qui soutiendra la démarche :

- performance : car la démocratisation des usages au même titre qu’une volumétrie croissante des données viendront malmener les infrastructures. La performance pourrait vite devenir la première victime du succès (de fait éphémère) de cette toute nouvelle autonomie donnée aux utilisateurs ;

- scalabilité : car les besoins viendront à se multiplier et qu’il deviendra indispensable de pouvoir accueillir ces changements en des temps records, sans remettre en question la qualité, la conformité, la sécurité ou l’exploitabilité du service rendu.

Sur le plan organisationnel, il conviendra de créer et orchestrer de nouveaux rôles dédiés à la valorisation de la donnée comme à sa collecte et à son façonnage amont. In fine, c’est l’animation d’une communauté data rapprochant équipes métiers et IT/BI qui représentera l’un des facteurs de succès de la démarche en relayant notamment :

- gouvernance : car la définition de politiques, processus, standards (notamment en matière de gestion des privilèges) et la clarification des rôles et responsabilités tout au long du cycle de vie de la donnée devront garantir les niveaux de disponibilité, intégrité, confidentialité et traçabilité de l’information ;

- changement : car le déploiement et le maintien de guides, de plans de formation et de canaux de communication appropriés (supports, publications, événements) contribueront à l’acculturation nécessaire à la transformation amorcée et favoriseront l’adhésion des différentes parties prenantes aux solutions déployées.

Trouver le bon curseur, la bonne approche, la bonne architecture sont autant de challenges auxquels il faudra se confronter pour mettre en œuvre le plus efficacement une démarche de Self-BI.

En conséquence, une recommandation s’impose : définir une feuille de route adaptée, privilégiant preuves de concepts et autres « quick wins » ou effets démonstrateurs en s’appuyant en premier lieu sur les populations métiers les plus matures tant en termes de compétences que d’usages.

Le cloud : un accélérateur à double tranchant

Et cette logique « des petits pas » s’illustre particulièrement en matière d’architecture. Comment bâtir un socle technologique qui réponde à l’ensemble des usages de la donnée au sein de l’entreprise ? Et par conséquent, comment intégrer les besoins liés au déploiement de la Self-BI ?

Les réponses à ces questions épineuses ne tombent jamais du ciel. Pourtant, nombreuses sont les organisations qui se tournent vers les nuages… D’ici 2025, 50% des entreprises appuieront leur transformation métier sur des architectures cloud distribuées, justifiant une place au top 3 des priorités achat dès 2023[2].

Et les motivations sont claires : plus simple, plus performant, plus agile et moins cher, avec en prime la possibilité souvent alléchante de changer de modèle de coût (du CAPEX vers l’OPEX) et de diminuer le TCO (Total Cost of Ownership) du SI. Un environnement tout désigné pour garantir l’ATAWAD (Any Time, Any Where, Any Data) recherché par l’implémentation d’une démarche Self-BI.

Simplification et valorisation : telles sont les attentes de ces architectures DaaS (Data as a Service) telles que rencontrées dans de nombreuses organisations puisqu’elles facilitent :

- l’ingestion et le stockage de multiples sources de données, qu’elles soient structurées, semi-structurées ou non structurées,

- l’accès au temps réel via le déploiement de technologies de CDC (Change data Capture) et le passage au mode ELT (Extraction, Load and Transform) par opposition au traditionnel ETL,

- l’implémentation de « sources uniques de vérité » permettant l’exposition de données Métier sécurisées, fiabilisées et traçables de bout en bout (data lineage).

Figure 4: xOPS – les clés d’une transition réussie vers le cloud

Et ces tendances à la modernisation des socles data ne rencontreront de succès et de ROI raisonnable (Return On Investment) qu’à condition de porter une attention particulière aux points suivants :

- l’implémentation puis le maintien en conditions opérationnelles et de sécurité de l’architecture choisie (hybride, multicloud…),

- le développement et la pérennisation de compétences, rôles et processus spécifiques à même de garantir l’agilité et la flexibilité recherchées,

- la gestion fine, opérationnelle et en continu des coûts liés à ces plateformes dont la pluralité des modèles et usages peut vite condamner toute tentative de maîtrise des budgets dédiés.

C’est donc en prenant « le virage des Ops » et en rapprochant les métiers du développement, de la sécurité, des opérations et des finances autour de la donnée et dans un cadre collaboratif efficace, que ces architectures donneront pleinement satisfaction.

Des choix forts et des investissements lourds qui figurent parfaitement de l’iceberg présenté plus haut et de l’ampleur de la tâche concernant l’implémentation de la Self-BI comme outil de pilotage de l‘entreprise par la donnée.

Et les différents fournisseurs du domaine en conviennent, car si les principaux acteurs présentent des solutions aux fonctionnalités similaires, c’est bien sûr les points présentés plus haut que la bataille fait rage.

En effet, les principales fonctionnalités qu’il faudra rechercher dans un outil de Self-BI sont les suivantes :

- la capacité à effectuer des analyses/requêtes sans ou avec peu de support de la part de l’équipe IT. Cette facilité de prise en main représentant le cœur de la Self-BI ;

- l’accès, la collecte et la manipulation de différentes sources de données. Capacité essentielle à la consolidation de vues 360° d’une problématique donnée ;

- enfin la multiplicité et la qualité des outils de data visualisation et de création de tableaux de bords permettant d’explorer et de représenter les données de façon précise et largement compréhensible, s’avèrent indispensables à toute solution de Business Intelligence.

Toutefois, il ne s’agit là que d’une base commune aux différents outils d’un marché ultra compétitif, ne permettant plus de les départager.

Il convient alors de se focaliser sur des critères relevant davantage du contexte d’implémentation de ces solutions que de leur valeur intrinsèque :

- Scalabilité et performance : à mesure que la quantité de données augmente et que les besoins en analyse sont en constante croissance, il est nécessaire de disposer d’un outil scalable, performant avec des capacités de calcul importantes (au même titre que l’ensemble des briques architecturales évoquées plus haut) ;

- Sécurité et contrôle d’accès : la sécurité des données est un élément critique à surveiller. La mise en place d’une gouvernance claire en définissant les rôles et privilèges d’accès permet de limiter les risques de compromission des données et d’en maitriser les niveaux de confidentialité. Une gestion fine des privilèges et la définition de modèles de delivery (business led et/ou IT managed) adaptés aux profils utilisateurs comme aux usages permettront ainsi de maîtriser les risques et coûts de déploiements ;

- Collaboration : afin de contribuer à la démocratisation des usages et au développement d’une culture de la donnée au sein de l’entreprise, la solution choisie doit faciliter la communication entre utilisateurs, le partage de données (publication) comme la production collaborative de tableaux de bords. Les capacités multi-devices seront également appréciées, notamment dans une optique de mobilité ;

- Data management : la Self-BI renvoie à la mise en œuvre d’une chaine complète de traitement de l’information. En conséquence, les solutions « de bout en bout » proposant une couverture exhaustive de cette chaine seront particulièrement appréciées. L’intégration de fonctionnalités de gestion de la qualité des données (Data Stewardship) ou encore de gestion centralisée des métadonnées (Data Catalogue ou Business Glossary) est indispensable au déploiement d’une vision commune et dé-silotée de l’information, facilitant sa compréhension par tous et libérant par là son usage ;

- Analytique avancée : si la multiplicité des connecteurs facilite l’intégration de nombreuses sources de données, elle permet également d’étendre les performances de la solution en embarquant des méthodologies d’IA de découverte, d’enrichissement, ou d’explication de données (cf. Machine Learning ou Deep Learning). Proche d’intégrer les fonctionnalités de bases citées plus haut, leur facilité d’implémentation et/ou degré d’intégration à la solution constitue un élément particulièrement différenciant.

- Offre cloud : la capacité d’un outil Self-service BI à s’inscrire dans un environnement cloud est devenue également inévitable. L’outil devra permettre non seulement de réaliser des analyses de données dans le cloud (qu’il soit public ou privé) mais aussi de s’intégrer dans des écosystèmes multiclouds et hybrides.

- Coût : les coûts d’achat, de mise en œuvre et d’exploitation doivent être pris en compte lors du choix de l’outil. Les fournisseurs mettant en avant des offres plus avantageuses avec une couverture complète arriveront à se démarquer notamment les fournisseurs cloud (tels que Microsoft, AWS, Google…).

[2] 100 data analytics predictions through 2025 – GARTNER

Alors « faire ou ne pas faire ? »

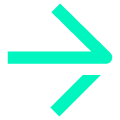

Finalement, la question n’est pas là. Et pour une fois, elle n’est pas non plus dans le « Pourquoi ? », la valeur potentielle pour l’entreprise n’étant plus à démontrer, quel que soit le domaine[3][4]. La question réside bien dans le « Comment ? ».

Figure 6: L’impact de l’analyse de données en temps réel par métier et secteurs d’activité [3][4]

La Self-BI n’est pas une fin en soi mais une composante essentielle d’une stratégie globale de valorisation de la donnée au sein de l’entreprise, visant à renforcer le pilotage de la performance Métier, accélérer et fiabiliser la prise de décision.

Elle représente un palier de maturité dans le rapport de l’entreprise à la donnée, et doit s’inscrire dans une démarche stratégique à moyen/long terme, mobilisant de nombreuses parties prenantes afin d’opérer le changement de culture associé.

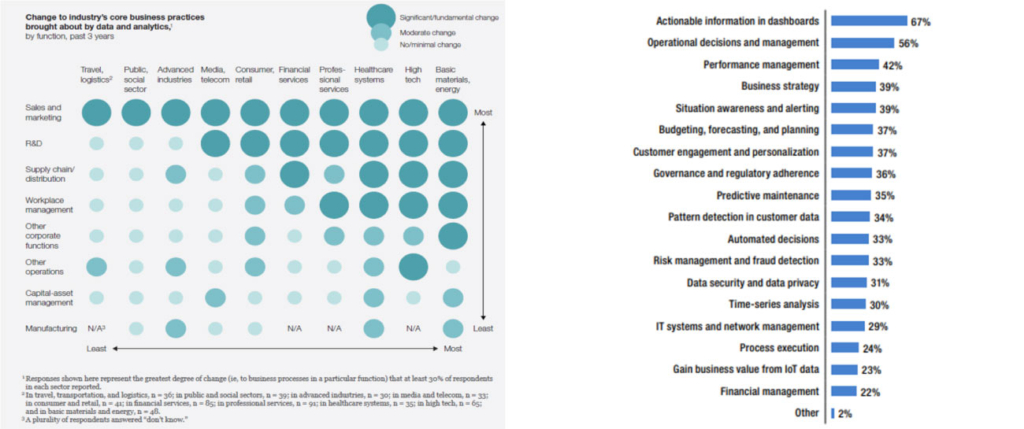

Figure 7: La Self-BI, une question de maturité [5]

Selon le référentiel du CMMI, un niveau de maturité « Defini » (3 sur une échelle de 5 niveaux), c’est-à-dire présentant des standards décrits et en application sur chacun des axes du modèle DMMSM, semble représenter une base solide pour l’implémentation efficace et sereine d’une démarche de Self-BI.

L’analyse n’est donc que la partie immergée de l’iceberg « Self-BI » dont la stabilité repose sur les étapes clés suivantes :

- L’établissement d’une stratégie ambitieuse, claire et pragmatique, alignant métier & SI au regard des enjeux de l’entreprise,

- La définition et l’animation d’une gouvernance transverse, mobilisatrice, tangible et efficace au quotidien,

- L’implémentation ou la modernisation d’une architecture performante, scalable, agile et sécurisée par design,

- Le développement et l’accompagnement d’une communauté dynamique et engagée, car seules ces forces vives donneront corps aux plans, processus et outillages déployés.

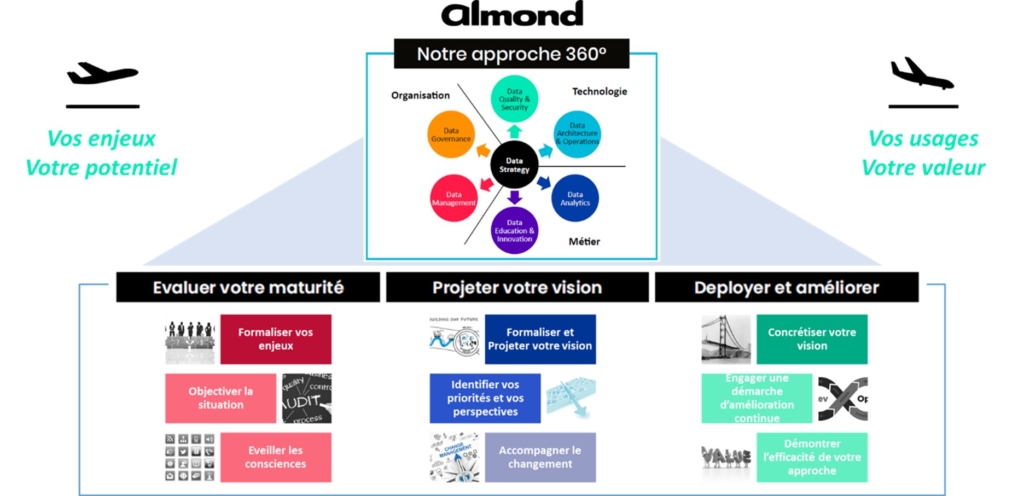

Figure 8: La Self-BI, une composante essentielle de votre stratégie Data

[3] Fueling growth through data monetization – MCKINSEY

[4] Faster Insights from Faster Data – best practice report 2020 – TDWI

[5] Why Is Measurement of Data Management Maturity (DMM)SM So Important? – CMMI

Imane ANTARI

Consultante Digital Technology

Alexandre MENICACCI

Consultant senior Digital Technology