19/05/2022

Digital Technology Insights

FinOps : l’éclaircie parmi les nuages

Digital Technology Insight

Le marché du cloud est en pleine expansion ; qu’il soit privé, public ou hybride – en IaaS, PaaS ou SaaS – chaque jour, des migrations massives sont conduites par les organisations. Permettant aux entreprises d’accélérer leur transformation digitale, en bénéficiant des dernières innovations technologiques et en facilitant l’accès à un catalogue de services fourni et des ressources illimitées à la demande, le cloud est aujourd’hui un levier incontournable.

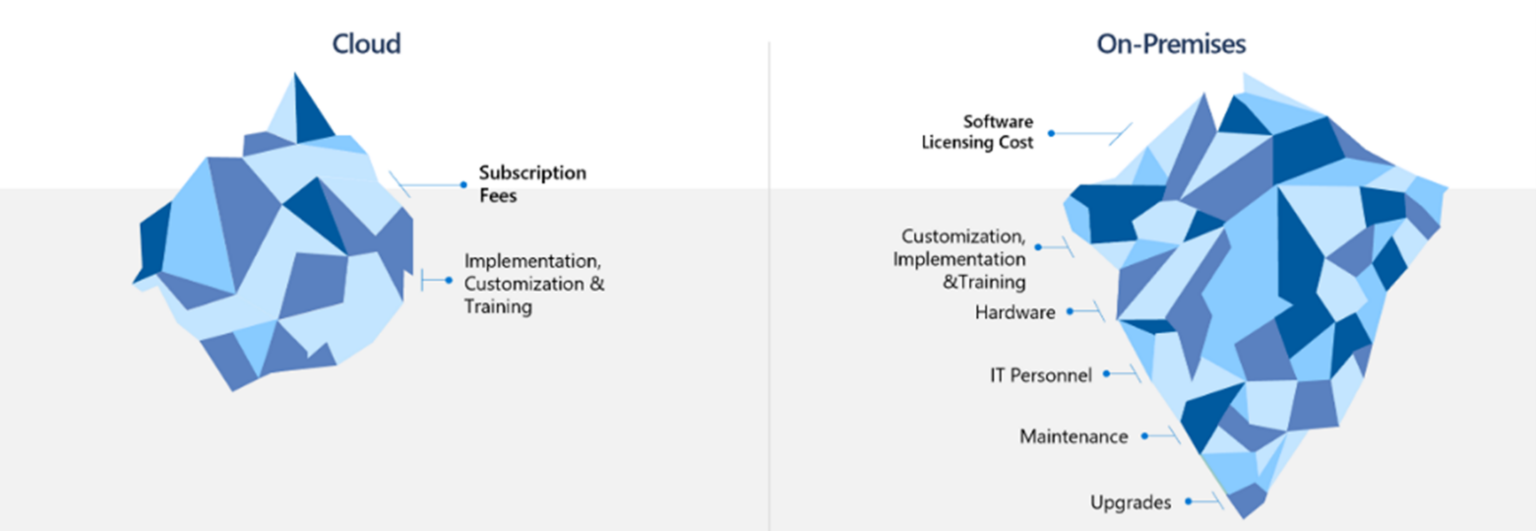

Or, tout n’est pas « bleu » dans le nuage. De nouveaux paradigmes sont introduits par la nature du modèle cloud, parmi eux : sécurité en profondeur et multicouches, conformité réglementaire, construction des services et gestion budgétaire. Cette dernière, longtemps un frein à l’innovation et à la souscription de nouveaux services, car « imprédictible », « non maitrisable », fait désormais figure d’alliée, pour driver les investissements créateurs de valeur pour l’entreprise.

Variabilité des coûts, difficulté de forecasting et complexité des factures sont donc les nouvelles menaces à convertir en opportunités pour faire du cloud un accélérateur business.

Figure 1 : répartition des coûts Cloud Vs On-Premise (Source : Microsoft)

Une multitude d’options tarifaires sont proposées par les fournisseurs de services cloud comme Amazon et Microsoft. Le choix des services cloud est devenu très difficile. AWS propose par exemple plus de 200 000 références de produits, dont certaines facturées à la seconde.

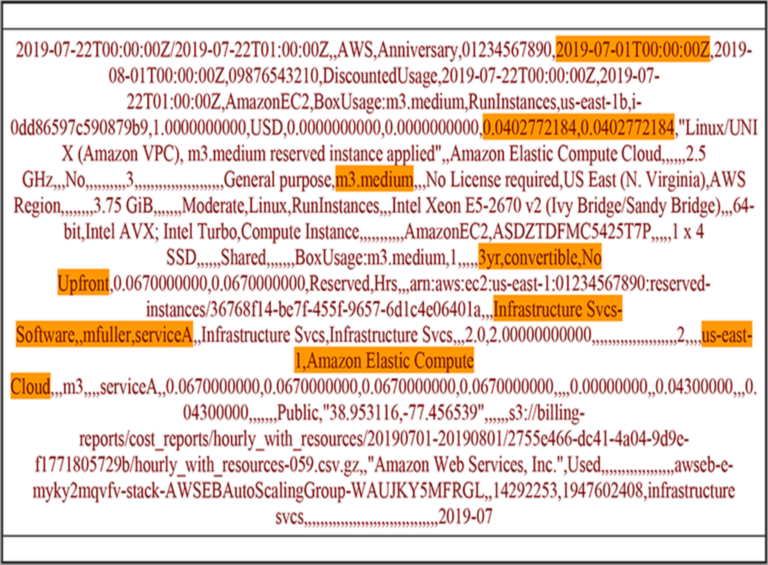

Quotidiennement, les clients reçoivent des centaines de millions de lignes de données de facturation de leur fournisseur cloud, sans visibilité entre les ressources consommées et les dépenses associées.

Figure 2 : Exemple d’une ligne de facturation AWS (Source : Cloud Finops)

Difficile de comprendre les différents attributs mais, en cherchant bien, on peut distinguer certains éléments :

- Le moment de l’utilisation de la ressource,

- Le tarif de facturation appliqué,

- La ressource facturée,

- Si une réservation de ressource a été appliquée ainsi que sa nature,

- Les attributs de métadonnées qui facilitent la répartition des coûts,

- La région géographique et le service utilisé.

Contrairement aux rapports de facturation des ressources On-Premise, les factures cloud ne sont pas exploitables manuellement. D’où l’importance de passer par un système plus performant pour pouvoir les traiter. Heureusement, les fournisseurs de services cloud comme AWS, GCP et AZURE proposent des outils pour analyser les dépenses cloud et avoir plus de visibilité sur les ressources consommées. Mais en l’absence de stratégie financière cloud et de compétences associées, les entreprises n’arriveront ni à appréhender et contrôler leurs dépenses, ni à optimiser leur consommation cloud ; et encore moins à identifier les investissements ROIstes à engager.

Il est donc important de mettre en place un dispositif de gouvernance très pointu pour piloter, suivre et mesurer les coûts engendrés par les ressources « cloud » et leurs impacts business.

L’approche FinOps apporte aux entreprises cette synergie recherchée : IT et financière, garantissant l’adhérence entre le design technique, le comportement de consommation des utilisateurs et la finance.

FinOps n’est pas une recette miracle pour réduire les dépenses cloud… En revanche, elle vise à :

- Comprendre le comportement de consommation des ressources cloud,

- Démontrer et suivre la valeur créée par la souscription à des ressources,

- Responsabiliser les équipes grâce aux mécanismes de « chargeback » ou/et « payback »,

- Optimiser les dépenses à travers un pilotage des ressources.

Au-delà des axes techniques et financiers, l’approche FinOps impose un cadre organisationnel structuré. La création d’un CCoE (Cloud Center Of Excellence) va garantir sa réussite en identifiant des rôles clés. Des compétences complémentaires vont ainsi pouvoir interagir ensemble : Lead FinOps, Lead Architect, Lead DevOps, Lead R&D… afin de contribuer à la mise en place et au maintien d’une gouvernance unifiée sur l’ensemble de la chaine des environnements cloud.

Le CCoE est évolutif et peut s’adapter à chaque typologie d’entreprise. Par exemple, dans les PME, l’approche FinOps peut être incarnée uniquement par un Lead FinOps (interne ou en temps partagé), chef d’orchestre du modèle et intervenant en étroite collaboration avec les équipes IT, afin de :

- Définir les objectifs métiers à suivre et la gouvernance à mettre en place,

- Définir la mise en place d’objectifs liés à la maîtrise des coûts au sein des équipes techniques,

- Définir la bonne mise en place des mesures pour assurer la transparence de la consommation, l’optimisation continue et le reporting,

- Définir le reporting, le modèle de refacturation et la politique d’achat,

- Mesurer le ROI des investissements cloud engagés.

Soukaïna DERAOUI

Consultante Digital Technology